A mai napon élesítették a Google Penguin 2.1 verzióját. Ez a pingvin nem az édi-bédi, Madagaszkár c. animációs filmből jött fajta, hanem a Google webes spam elleni küzdelmet célzó algoritmusainak a kódneve. A jelenlegi frissítés vélhetően a weblapok 1%-át érinti majd. A kereső fejlesztői folyamatosan igyekeznek a webes spam ellen felvenni a küzdelmet, de ennek sajnos vannak mellékhatásai.

„Google Penguin 2.1 élesítve” bővebben

Form + Javascript = Duplicate Content?

Érdemes óvatosan bánnunk azokkal a formokkal, select elemekkel, amelyek nem tényleges formok, csak javascript-tel dolgozzuk fel őket. A keresőrobotok fejlesztői a formokat nem éppen megfelelően kezelik, emiatt könnyen indexelésre kerülhet néhány (vagy néhány ezer) oldalunkból több „másolat” is.

Már a robots.txt sem szent?

Nem ragozom sokat, nyilván mindenki tudja, hogy a robots.txt fájl mire is való. Röviden, egyszerűen a célja az lenne, hogy egy weblap gazdája meghatározhassa, hogy a weblapjának mely részéről kívánja kizárni a kereső, gyűjtő és egyéb robotokat. Sok alkalmazás valóban figyelembe is veszi a robots.txt fájlban meghatározott korlátozásokat. Sok igen … csak épp nem mindegyik. Az gondolom senkit nem lep meg, hogy az email cím betakarító robotok nem foglalkoznak ezzel. Azonban sokak számára meglepetés lehet, hogy a legnagyobb cégek robotjai is csak afféle kalóztörvényként tekintenek a robots.txt-re, ami ugye nem is törvény, inkább csak afféle ajánlás…

„Már a robots.txt sem szent?” bővebben

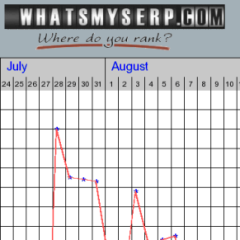

Hasznos oldalak 6. – WhatsMySerp.com

Ma a WhatsMySerp.com oldalt ajánlom a figyelmetekbe. Egy weblapfejlesztőnek, SEO szakembernek kiemelten fontos a SERP folyamatos ellenőrzése. Nyomon kell követni, hogy a weblapjaink adott kulcsszavakra hányadikként kerülnek elő a keresők találati listájában. Enélkül a visszajelzés nélkül szinte lehetetlen a megfelelő SEO stratégia kialakítása, és az esetlegesen megváltozó körülményekhez igazítása.

„Hasznos oldalak 6. – WhatsMySerp.com” bővebben

Mennyire fontosak a Schema.org jelölések?

A napokban belefutottam egy érdekes problémába. A Google+ szolgáltatásban megosztott linkekhez a G+ több weblapnál nem vette figyelembe a weblapon szereplő leírást (meta description), és az átvett link is furcsa volt (egy látszólag oda nem illő #_sid=0 került a végére). A hibajelenség nem minden lapot érintett, de a problémás lapok egytől egyig korszerű, érvényes HTML5-re épülő oldalak voltak, Schema.org jelölésekkel. 1-2 WordPress alapon, 1-2 saját motorral.

„Mennyire fontosak a Schema.org jelölések?” bővebben

Miért változik meg a lapom címsora a SERP-ben?

Biztosan sokan belefutottatok már az alább taglalt problémába, de egy újszülöttnek minden vicc új. (Még akkor is, ha webmester az illető.) Miért is változtatják meg a keresők a találati listákban (SERP) az oldalunk címét? A kérdés jó, de tényleges és korrekt válasz nincs. Nem sorolom a korrekt válaszok közé azt, ha a képünkbe vágja valaki, hogy „CSAK”. Még akkor sem, ha hozzáteszi, hogy ezzel nekünk (béna) webmestereknek, és persze a felhasználóknak, olvasóknak akarnak jót.

Köszönöm szépen, de majd én eldöntöm mi a jó nekem. Ez nem az…

Hasznos oldalak 4. – Open Site Explorer

Ma az Open Site Explorert ajánlom a figyelmetekbe. Ezen a lapon ellenőrizhetitek, hogy az oldalatokra mennyi link mutat, és ezek tekintetében hogyan viszonyul a lapotok a konkurens lapokhoz. Nem hangzik túl komplikált feladatnak, de ezen a lapon kívül nem sok helyen ellenőrizhetitek ezeket a paramétereket mióta a keresőkben nagyrészt hiába kerestek a régi jó link:domain.com módszerrel.

PageRank plugin Chrome böngészőhöz

A webmesterek és SEO szakemberek munkáját rengeteg eszközzel könnyítik meg a fejlesztők. Persze, az eszközök egy része drága, más része csiricsáré, de szinte használhatatlan. Van azonban néhány, amely ingyenes és mégis használható. Ezek közül ajánlok ma egyet, amelyet én gyakran és szívesen használok. A neve nem túl fantáziadús: PageRank.

Egy Chrome pluginről van szó, Nem elhanyagolható tény, hogy az alább ismertetett plugin teljesen ingyenes. Legalábbis nem kell pénzzel fizetnünk érte, de erre még egy későbbi cikkemben visszatérek…

Hogyan tiltsunk ki robotokat?

Napjainkban a webes forgalmak jelentős részét robotok generálják. Ennek a forgalomnak egy részére szükségünk van, hiszen a webes keresők adatbázisába szeretnénk bejuttatni a lapunkat, tehát az indexeléshez kellenek bizonyos botok. Vannak azonban olyan automatizált rendszerek, amelyeket egyáltalán nem látunk szívesen az oldalunkon. Némelyik olyan adatot gyűjt (pl. e-mail címeket), amelyet nem feltétlenül szeretnénk egy adatbázis részeként viszontlátni, mások egyszerűen csak a szerverterhelésben okoznak problémát.

„Hogyan tiltsunk ki robotokat?” bővebben

Miért kell legalább 300 szó egy oldalra?

Biztosan hallottál már arról, hogy egy weboldalnak legalább 300 szót kell tartalmaznia a tartalmi részben. A 300 szó nem kevés, de ha nem vesszük figyelembe ezt az elvárást, akkor máris hátrányba kerülhet a lapunk a konkurencia lapjaival szemben. Nem szabad azonban csak a keresőknek alárendelni a lapunkat, egy tréfás kép mellé finoman szólva is hülyeség 300 szónyi értelmetlen, töltelék maszlagot írni.